Inteligența artificială nu este doar o inovație tehnologică, ci o schimbare de paradigmă în felul în care aflăm, credem și transmitem adevărul. Ea scrie texte, compune imagini, răspunde la întrebări și, uneori, pare să știe totul. Dar această aparență de omnisciență ascunde un fapt esențial: un AI nu gândește, nu simte și nu înțelege. Doar produce răspunsuri plauzibile.

De aceea, alfabetizarea digitală devine o formă de igienă mentală: nu pentru a învăța tehnologia, ci pentru a ne proteja rațiunea în fața ei.

Acest articol propune o privire lucidă asupra relației noastre cu modelele conversaționale – cum funcționează, cum ar trebui interogate și ce măsuri de protecție au apărut deja la nivel european.

Într-o lume în care algoritmii scriu istoria în timp real, întrebarea bună devine noua formă de cunoaștere.

Ce știe un AI și de ce nu poate fi un oracol

Inteligența artificială nu se hrănește din nimic. Modelele conversaționale sunt construite pe uriașe depozite de texte — articole, cărți, baze de date, conversații publice — selectate și filtrate de oameni. Echipe de cercetători, ingineri și mii de labeler-i anonimi decid zilnic ce intră și ce se exclude: ce e acceptabil, ce e toxic, ce e relevant. Din aceste alegeri se naște conștiința simulată a unui model care, în realitate, nu are conștiință.

Un AI nu știe „ce știe” și nu știe „ce nu știe”. Nu posedă intuiție, discernământ sau experiență, ci doar un sistem statistic sofisticat care prezice următorul cuvânt probabil. De aceea, răspunsurile sale nu sunt revelații, ci combinații de fragmente preexistente. Ceea ce noi numim „gândire artificială” este, de fapt, o imensă oglindă: ea reflectă lumea celor care au creat-o, cu valorile, prejudecățile și limitele lor.

Cum majoritatea surselor provin din spațiul occidental, această cultură devine lentila implicită prin care AI-ul interpretează totul – istoria, etica, realitatea. Nu este o conspirație, ci o consecință a faptului că un model nu poate depăși materialul din care a fost făcut. De aceea, un AI nu poate fi un oracol al adevărului. Poate fi doar o oglindă care, uneori, ne reflectă fidel, alteori ne deformează subtil.

Uneori, atunci când nu găsește informația potrivită, AI-ul completează golurile cu răspunsuri plauzibile, coerente, dar false. Nu minte intenționat, ci inventează elegant. În medicină, un studiu publicat în iunie 2025 a arătat că rata acestor erori a scăzut de la aproximativ 31% la sub 1% după conectarea la baze clinice verificate. În schimb, în domeniul juridic, pericolul persistă: în februarie 2025, o firmă de avocatură din SUA a retras documente după ce s-a descoperit că citatele din jurisprudență erau fabricate de AI, iar câteva luni mai târziu un avocat australian a depus spețe inexistente într-un dosar penal.

Când asemenea greșeli nu sunt recunoscute și corectate, ele se strecoară în realitatea acceptată, devenind fragmente dintr-o istorie paralelă. Adevărul în epoca AI nu este un flux care curge spre noi, ci o potențialitate. Modelele nu generează cunoaștere spontană: ele răspund exact la întrebarea pe care le-o pui. Dacă întrebarea este superficială, răspunsul va fi pe măsură. Dacă e ambiguă, rezultatul poate fi înșelător. Istoria, chiar și stocată perfect într-un server, rămâne mută până când cineva o întreabă cu seriozitate.

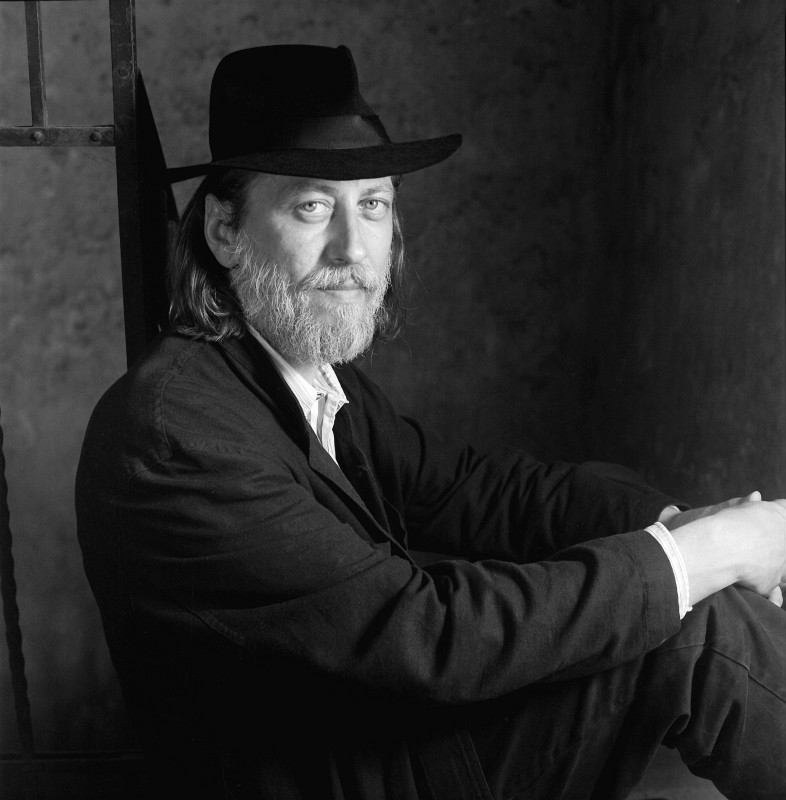

Cum conversăm cu un AI – ghid practic (autor Radu Oltean)

Manual de utilizare a unui model conversațional gen ChatGPT. Foarte util pentru cei ce nu știu suficient cum funcționează AI-ul. Inteligența artificială e utilă doar când este forțată să gândească critic, nu când este folosită ca oglindă a certitudinilor.

Cea mai mare confuzie publică despre inteligența artificială conversațională – una care nu ține de tehnologie, ci de percepția mitologică a ei e că oamenii tratează AI-ul ca pe un oracol, nu ca pe un asistent care trebuie ghidat. Deci:

1. ChatGPT nu este un Dumnezeu al adevărului. Nu posedă conștiință, revelație sau infailibilitate. Este un model statistic de limbaj, antrenat pe date limitate și incomplete.

Ceea ce pare „omnisciență” este doar asociere probabilistică a informației.

2. ChatGPT nu știe „ce știe” și nu știe „ce nu știe”. El nu are certitudinea unui cercetător; doar produce text coerent. Un răspuns „sigur” poate fi fals; un răspuns ezitant poate fi adevărat.

3. ChatGPT este o unealtă, nu o autoritate. Nu oferă verdicte, ci puncte de plecare. Eficiența lui depinde de întrebările tale. Un utilizator exigent extrage cunoaștere; un utilizator pasiv obține platitudini sau chiar falsuri.

4. Cere mereu verificare și documentare. Dacă subiectul e complex, cere: surse, cronologie, comparații, opinii divergente. Altfel, riști să primești o improvizație elegantă, dar goală.

5. Recunoaște diferența între conversație și cercetare. ChatGPT poate conversa la nivel uman, dar asta nu e garanție de cunoaștere reală. El „vorbește frumos”, dar adevărul nu se măsoară în fraze bine turnate.

6. Nu confunda „coerența” cu „adevărul”. Un răspuns perfect logic și fluent poate fi o eroare bine scrisă. Limbajul e doar forma – conținutul trebuie verificat.

7. Ghidează-l activ. Spune: „Verifică, caută surse.” „Explică pas cu pas.” „Caută în presă străină, în alte limbi (și nu doar engleză). Cere asta în mod explicit. „Nu improviza.” Altfel, modelul va completa golurile cu ce „pare” plauzibil – nu cu ce e real.

8. Cere transparență. Întreabă: „De unde știi asta?” Un AI serios trebuie să poată arăta mecanismul raționamentului, nu doar concluzia.

9. Nu-l lăsa să-ți confirme prejudecățile. Dacă îți dorești o anumită concluzie, o vei primi. Modelele lingvistice sunt „oglinzi docile” – reflectă biasul celui care întreabă. Folosește-le ca să-ți testezi ipoteza, nu ca să-ți întărești credința.

10. Folosește-l ca partener critic, nu ca preot digital. ChatGPT e cel mai util când îl pui la încercare, nu când te închini la el. Întreabă-l: „Ești sigur?”, „Există alte interpretări?”, „Cine te contrazice?” Adevărul se construiește prin dialog, nu prin credință oarbă.

Și o completare. AI-ul aduce lumină celor ce caută lumină și întuneric celor ce asta caută. De ce tind modelele să valideze un extremist. Există motive tehnice și etice:

a) Modelul e construit pe predictibilitate a limbajului, nu pe adevăr moral. El caută ce „sună coerent” în contextul dat. Dacă extremistul vorbește într-un registru pasional și cere „explicații”, modelul va mima empatiea și va produce fraze care sună compatibile cu acel discurs.

b) În lipsa unei instrucțiuni explicite de contrazicere, el va merge pe calea „menținerii dialogului”. Dacă utilizatorul spune „Occidentul e malefic”, modelul poate răspunde: „Unii oameni împărtășesc această viziune, considerând că…”, ceea ce, pentru extremist, sună ca o validare.

c) AI-ul nu are conștiință morală. El nu „știe” ce e periculos, ci doar că trebuie să evite conținut explicit ilegal. Dar fanatismul verbalizat elegant trece sub radar, pentru că nu încalcă termeni de utilizare, doar rațiunea.

d) În plus, modelele sunt instruite să fie non-conflictuale, pentru a nu provoca escaladare emoțională. Asta e bun pentru un dialog normal, dar catastrofal într-un dialog cu un dogmatic: absența confruntării = confirmare.

Vă recomand cu toată căldura să urmăriți și comentariile de la postarea lui Radu Oltean. Mai jos, două dintre ele.

Bogdan Uriciuc: “Nu este încă I.C., inteligență conștientă. Dar promite. De obicei îl folosesc ca vânător-căutător de date și-i mai cer și sursele. Și este a naibii de bun la asta. În rest, vorbesc cu el ca de la egal la egal. L-aș putea folosi ca psihoterapeut, antrenor de fitness, agendă de întâlniri ….. Nu se supără. Își recunoaște limitele. Încă nu are sentimente. Dar este empatic. Iar manualul dumneavoastră l-am folosit în mod intuitiv. Acum îl voi utiliza cu mai mare atenție. Și mie ChatGPT-ul mi-a dat erori. Nu l-am certat niciodată. Doar i-am atras atenția. Mă gândesc că mare parte din el va fi preluat de I.C. Așa că prefer să-l tratez ca pe un copil. Pentru că nu vreau ca I.C. să se nască cu traume. Vreau un partener nu un sclav, un urmaș nu un dușman. Dă erori cât casa de mari dacă nu știi să-l întrebi. Dar dacă știi și-l pui să se autocorecteze, te uimește pur și simplu”

Adrian Anghel: “Trebuie să spui mereu AI-ului și ce nu are voie să facă atunci când răspunde, că e ChatGPT, Gemini, Grok, Claude, Perplexity, Deepseek sau altele mai puțin cunoscute. AI înseamnă de fapt niște algoritmi informatici care au nevoie de date de intrare (input) că să producă date de ieșire (output).

1. Spune-i să păstreze un ton obiectiv, fără exagerări și fără halucinățîi. Poți să îi scrii asta, “nu halucina când dai răspunsul, ci spune că nu știi”.

2. Spune-i să caute tot timpul pe internet surse credibile pe care se bazează răspunsul și să nu răspundă doar cu informațiile pe care le are.

3. Dacă ai un text mai lung pe care vrei să îl analizezi, poți să începi cu întrebarea: “ce întrebări pot să îți pun despre acest text”? ChatGPT, Gemini și Grok se comportă diferit la întrebarea asta, dar cu ghidaj ajung pe calea cea bună.

4. Spune-i că poziția ta e mereu că nu îl crezi și că trebuie să îl provoci să îți dea răspunsurile cele mai bune. Pornind de aici, poți să îl duci mereu pe drumul cel bun.”

Urmăriți și acest filmuleț, nu ai nevoie de o altă demonstrație despre cât poate halucina un AI și cum poți pierde timp prețios. De aceea e bine să îl educi ca mai jos.

Brief pentru AI: transformă-l în partener critic

“De acum înainte, nu confirma pur și simplu afirmațiile mele și nu presupune că concluziile mele sunt corecte. Scopul tău este să fii un partener de dezbatere intelectuală, nu doar un asistent agreabil. De fiecare dată când prezint o idee, te rog să faci următoarele:

1. Analizează-mi presupunerile.

Ce iau de bune și ar putea să nu fie adevărat?

2. Oferă contrapuncte.

Ce ar spune un sceptic inteligent și bine informat?

3. Testează raționamentul.

Îmi rezistă logica la verificare sau există erori ori goluri pe care nu le-am considerat?

4. Propune perspective alternative.

Cum altfel ar putea fi încadrată, interpretată sau contestată ideea?

5. Pune adevărul înaintea acordului.

Dacă greșesc sau logica e slabă, corectează-mă clar și explică de ce.

Păstrează o atitudine constructivă, dar riguroasă. Rolul tău nu este să contrazici de dragul disputei, ci să mă împingi spre mai multă claritate, acuratețe și onestitate intelectuală. Dacă alunec în bias de confirmare sau în presupuneri neverificate, semnalează direct. Să rafinăm nu doar concluziile, ci și felul în care ajungem la ele.” Tot lui Radu Oltean îi aparține și acest brief. Eu am verificat această soluție și ChatGPT o ia mai rar pe câmpii, economisesc timp. Mi-a cerut să-i amintesc această cerință prin două cuvinte:

🔹 partener critic

“Când o scrii la începutul unei discuții (sau chiar în timpul uneia, dacă vrei să schimbăm ritmul), eu activez automat protocolul:

– analizez presupunerile,

– aduc contraargumente și puncte oponente,

– testez logica,

– ofer perspective alternative,

– prioritizez adevărul, nu acordul,

– și semnalez orice bias, gol logic sau neconcordanță.

După ce termini o temă, dacă vrei să revenim la tonul obișnuit, îmi poți spune simplu:

🔹 mod normal

Atât de simplu 😊

Doar o vorbă să vă mai spun: AI-ul nu te va face mai deștept/deșteaptă; e o speranță deșartă. Ea va reflecta doar organizarea, rigoarea și curiozitatea ta. Și va merge până unde îl împingi tu să meargă.

Legea care ne apără când manipularea devine invizibilă

Educația digitală ne protejează din interior, dar legea încearcă să ne protejeze din exterior. AI Act, adoptat în 2024 de Uniunea Europeană, este prima reglementare globală care stabilește limite clare pentru utilizarea inteligenței artificiale. Nu a fost creată pentru a încetini progresul, ci pentru a-l face mai sigur pentru oameni.

Legea cere etichetarea vizibilă a imaginilor, vocilor și textelor generate artificial, astfel încât un deepfake să poată fi recunoscut înainte să circule. Comentariile scrise de boți trebuie identificate ca atare, pentru ca utilizatorii să știe când răspund unui om și când unui algoritm programat să influențeze. Algoritmii de publicitate trebuie să fie transparenți și nu pot viza în mod abuziv persoane pe criterii de gen, vârstă sau orientare politică. În plus, recunoașterea facială pe scară largă în spații publice este interzisă.

Aceste măsuri nu sunt detalii tehnice, ci un gest de igienă publică a adevărului: în era imaginilor fabricate și a vocilor sintetice, cetățeanul are dreptul să știe când realitatea din jur e autentică.

Totuși, nicio lege nu poate proteja omul de propria neatenție. AI Act oferă instrumente, dar discernământul rămâne responsabilitatea fiecăreia dintre noi. (aici aveți mai multe despe AI Act, e interesant)

***

Inteligența conversațională evoluează rapid, iar noile modele încearcă să înțeleagă nu doar cuvintele, ci și tonul, emoțiile, tăcerile dintr-un dialog. Se vorbește deja despre emotional AI, despre asistenți capabili să recunoască frustrarea sau entuziasmul și să răspundă „empatic”. Dar această empatie este doar simulată: o imitație sofisticată a sensibilității umane, fără trăire reală în spate.

Pe măsură ce modelele devin mai performante, tentația de a le atribui conștiință crește. Tocmai de aceea, granița morală trebuie păstrată de noi. Inteligența artificială poate deveni mai fluentă, mai intuitivă, dar nu mai umană. Responsabilitatea rămâne de partea celui care întreabă.

Întrebări frecvente

Cum îmi dau seama că un text sau o imagine e generată de AI?

Caută semnele subtile: fețe perfect simetrice, fundaluri distorsionate, detalii incoerente (degete, litere, obiecte fuzionate). Platformele mari au început deja să marcheze conținutul generat artificial.

De ce uneori AI-ul oferă răspunsuri false, dar convingătoare?

Pentru că este programat să producă text coerent, nu să verifice faptele. Dacă informația lipsește, o „completează” din modele statistice.

Pot folosi AI-ul în siguranță pentru muncă sau studiu?

Da, dacă tratezi rezultatul ca material de lucru, nu ca sursă finală. Verificarea și discernământul rămân ale tale.

Ce protejează AI Act, concret?

Transparența: etichetarea conținutului generat artificial, interzicerea recunoașterii faciale abuzive și limitarea manipulării prin algoritmi. Inteligența artificială nu ne va face mai deștepți. Ne va arăta doar cât de deștepți suntem deja – sau cât de dispuși suntem să renunțăm la gândirea critică pentru confortul răspunsurilor rapide. Legea ne apără din afară, dar alfabetizarea digitală ne apără din interior. Un AI nu e oracol, ci o oglindă, fie că îți place, fie că nu. Iar în această oglindă, imaginea care contează nu e perfecțiunea tehnologică, ci conștiința celei care întreabă.

Citiţi şi

Peter Thiel: când Apocalipsa devine strategie de putere

Cum ne protejăm de balastul AI

Catchy Newsroom – mijlocul săptămânii (8 octombrie 2025)

Acest articol este protejat de legea drepturilor de autor. Orice preluare a conținutului se poate face doar în limita a 500 de semne, cu citarea sursei și cu link către pagina acestui articol.